O nível de significância nas estatísticas é um indicador importante que reflete o grau de confiança na precisão e verdade dos dados recebidos (previstos). O conceito é amplamente utilizado em vários campos: desde a pesquisa sociológica até o teste estatístico de hipóteses científicas.

Definição

O nível de significância estatística (ou resultado estatisticamente significante) mostra qual é a probabilidade de ocorrência acidental dos indicadores estudados. A significância estatística geral do fenômeno é expressa pelo coeficiente de valor de p (nível-p). Em qualquer experimento ou observação, é provável que os dados obtidos sejam devidos a erros de amostragem. Isto é especialmente verdade para a sociologia.

Ou seja, uma estatística é estatisticamente significativa, cuja probabilidade de ocorrência acidental é extremamente pequena ou tende a extremos. Extremo, neste contexto, é considerado o grau de desvio da estatística da hipótese nula (uma hipótese que é verificada quanto à consistência com os dados da amostra obtida). Na prática científica, o nível de significância é escolhido antes da coleta de dados e, como regra, seu coeficiente é de 0,05 (5%). Para sistemas em que valores precisos são extremamente importantes, esse indicador pode ser de 0,01 (1%) ou menos.

Plano de fundo

O conceito de nível de significância foi introduzido pelo estatístico e geneticista britânico Ronald Fisher em 1925, quando desenvolveu uma metodologia para testar hipóteses estatísticas. Ao analisar um processo, há uma certa probabilidade de certos fenômenos. Dificuldades surgem quando se trabalha com probabilidades percentuais pequenas (ou não óbvias) que se enquadram no conceito de "erro de medição".

Ao trabalhar com estatísticas que não são específicas o suficiente para verificar, os cientistas foram confrontados com o problema da hipótese nula, que “interfere” com pequenas quantidades. Fisher sugeriu definir para tais sistemas probabilidade de eventos 5% (0,05) como uma fatia seletiva conveniente, permitindo rejeitar a hipótese nula nos cálculos.

A introdução de um coeficiente fixo

Em 1933, os cientistas Jerzy Neumann e Egon Pearson em suas obras recomendaram com antecedência (antes da coleta de dados) para estabelecer um certo nível de significância. Exemplos do uso dessas regras são claramente visíveis durante a eleição. Suponha que haja dois candidatos, um dos quais é muito popular, e o segundo é pouco conhecido. Obviamente, o primeiro candidato vence a eleição e as chances do segundo tendem a zero. Eles se esforçam - mas não iguais: há sempre a probabilidade de força maior, informações sensacionais, decisões inesperadas que podem mudar os resultados eleitorais previstos.

Neumann e Pearson concordaram que o nível de significância proposto por Fisher de 0,05 (denotado pelo símbolo α) é mais conveniente. No entanto, o próprio Fisher em 1956 se opôs à fixação desse valor. Ele acreditava que o nível de α deveria ser estabelecido de acordo com circunstâncias específicas. Por exemplo, na física de partículas é 0,01.

Valor P

O termo p-value foi usado pela primeira vez no trabalho de Brownley em 1960. P-level (p-value) é um indicador inversamente relacionado à verdade dos resultados. O maior coeficiente de valor p corresponde ao menor nível de confiança na amostra de dependência entre as variáveis.

Este valor reflete a probabilidade de erros associados à interpretação dos resultados. Suponha p-level = 0.05 (1/20). Mostra a probabilidade de cinco por cento de que a relação entre as variáveis encontradas na amostra é apenas uma característica aleatória da amostra.Isto é, se esta dependência estiver ausente, então com repetidos experimentos, em média, em todo vigésimo estudo, pode-se esperar a mesma ou maior dependência entre as variáveis. Frequentemente, o nível p é considerado como a “margem aceitável” do nível de erro.

By the way, p-valor pode não refletir a relação real entre as variáveis, mas mostra apenas um determinado valor médio dentro das hipóteses. Em particular, a análise final dos dados também dependerá dos valores selecionados desse coeficiente. Com um p-level = 0,05, haverá alguns resultados, e com um coeficiente de 0,01, outros.

Testando hipóteses estatísticas

O nível de significância estatística é especialmente importante ao testar hipóteses. Por exemplo, ao calcular um teste frente e verso, a área de rejeição é dividida igualmente em ambas as extremidades da distribuição da amostra (em relação à coordenada zero) e a verdade dos dados é calculada.

Suponha que, ao monitorar um determinado processo (fenômeno), a nova informação estatística indicasse pequenas mudanças em relação aos valores anteriores. Além disso, as discrepâncias nos resultados são pequenas, não óbvias, mas importantes para o estudo. O dilema surge antes do especialista: as mudanças realmente estão ocorrendo ou esses erros de amostragem (medições imprecisas)?

Neste caso, a hipótese nula é usada ou rejeitada (todas atribuídas a um erro, ou a mudança no sistema é reconhecida como um fato consumado). O processo de resolução do problema baseia-se na relação entre a significância estatística total (valor-p) e o nível de significância (α). Se o p-nível <α, então a hipótese nula é rejeitada. Quanto menor o valor p, mais significativa é a estatística de teste.

Valores usados

O nível de significância depende do material que está sendo analisado. Na prática, os seguintes valores fixos são usados:

- α = 0,1 (ou 10%);

- α = 0,05 (ou 5%);

- α = 0,01 (ou 1%);

- α = 0,001 (ou 0,1%).

Quanto mais precisos forem os cálculos, menor será o coeficiente α. Naturalmente, as previsões estatísticas em física, química, produtos farmacêuticos, genética exigem maior precisão do que na ciência política, na sociologia.

Limiares de relevância em áreas específicas

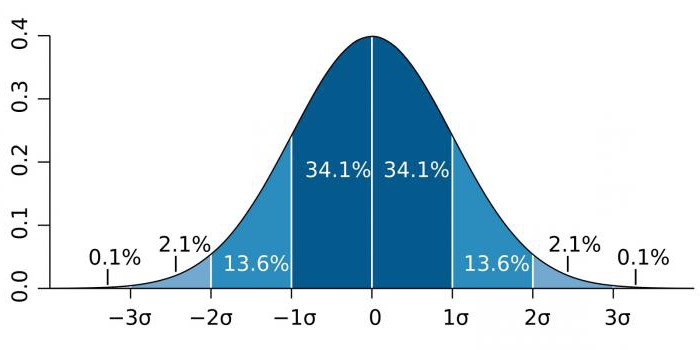

Em áreas de alta precisão, como física de partículas e atividades de fabricação, a significância estatística é frequentemente expressa como a razão entre o desvio padrão (denotado pelo coeficiente sigma - σ) em relação à distribuição normal de probabilidade (distribuição gaussiana). σ é um indicador estatístico que determina a dispersão de valores de um determinado valor em relação às expectativas matemáticas. Usado para traçar a probabilidade de eventos.

Dependendo do campo de conhecimento, o coeficiente σ varia muito. Por exemplo, ao predizer a existência do bóson de Higgs, o parâmetro σ é cinco (σ = 5), o que corresponde ao valor p-valor = 1 / 3,5 milhões.Em estudos de genomas, o nível de significância pode ser 5 × 10-8que não são incomuns para esta área.

Eficácia

Tenha em mente que os coeficientes α e p-value não são características precisas. Seja qual for o nível de significância na estatística do fenômeno estudado, não é uma base incondicional para aceitar a hipótese. Por exemplo, quanto menor o valor de α, maior a chance de que a hipótese estabelecida seja significativa. No entanto, existe um risco de erro, o que reduz o poder estatístico (significância) do estudo.

Pesquisadores que se concentram apenas em resultados estatisticamente significativos podem obter conclusões errôneas. Ao mesmo tempo, é difícil verificar novamente o seu trabalho, uma vez que eles usam suposições (que, de fato, são os valores de α e p-valor). Portanto, é sempre recomendável, juntamente com o cálculo da significância estatística, determinar outro indicador - a magnitude do efeito estatístico. A magnitude de um efeito é uma medida quantitativa da força de um efeito.