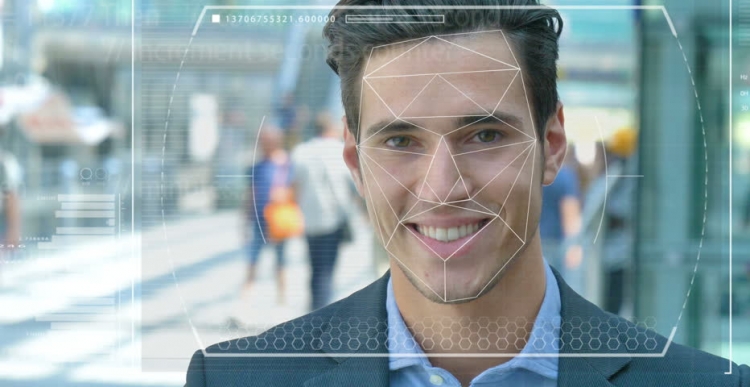

La policia i les forces de seguretat de tot el món estan provant sistemes automatitzats de reconeixement de la cara per utilitzar-los com a eina per identificar criminals i terroristes. Però, quina precisió és aquesta tecnologia i amb quina facilitat i la intel·ligència artificial (AI), sobre la qual funciona, es converteixen en eines de persecució i opressió?

Característiques del sistema

Imagineu-vos que un sospitós terrorista és enviat a una missió de suïcidi a un centre de la ciutat densament poblada. Si cau una bomba, centenars de persones poden morir o ferir greument. El procediment d’escaneig de cares en una multitud mitjançant videovigilància permet identificar un atacant i compara automàticament les seves característiques amb fotografies en una base de dades de terroristes famosos o “persones d’interès” amb els serveis de seguretat.

En cas de coincidència, el sistema aixeca l'alarma i les forces antiterroristes de reacció ràpida són enviades al lloc on "neutralitzen" el sospitós abans que pugui activar els explosius. Centenars de vides salvades gràcies a la tecnologia moderna.

Possibles problemes a la feina

Però, i si la tecnologia de reconeixement facial (FR) no funcionés correctament? I va resultar no ser un terrorista, sinó una persona corrent que només tenia mala sort i va resultar ser com un atacant. Una vida innocent hauria estat simplement destruïda perquè els experts també creien en un sistema erroni. Però, i si resulta ser una persona així?

Aquest és només un dels dilemes ètics que afronta el sistema de reconeixement facial i la intel·ligència artificial. És molt difícil formar màquines per “veure”, reconèixer i distingir objectes i cares. Utilitzant la visió per ordinador, com de vegades s’anomena, no fa gaire, els investigadors van intentar determinar la diferència entre els bolls amb panses i el chihuahua, que es va convertir en una espècie de test de litmus per determinar l’eficàcia d’aquesta tecnologia.

Afrontar dificultats de reconeixement

Els tecnòlegs informàtics, Joy Buolamvini, en representació del laboratori de l’Institut Tecnològic de Massachusetts (i alhora fundador de la Lliga de Justícia Algorítmica), i Timnit Gebru, codirector tècnic de l’equip de Google sobre qüestions ètiques relacionades amb la intel·ligència artificial, van mostrar que el sistema de reconeixement facial és difícil. distingeix entre homes i dones si la pell és prou fosca. El sistema confonia amb freqüència les dones amb la pell fosca dels homes.

"Al voltant de 130 milions de nord-americans adults ja es troben en bases de dades de reconeixement facial", va dir el doctor Gebru el mes de maig a l'AI per a la Cimera Bona a Ginebra. "Però els conjunts de dades originals contenen majoritàriament representants de la raça blanca, entre els quals hi ha molt més homes." Per tant, quan es reconeixen persones amb un tipus de pell més fosca, encara hi ha un percentatge enorme d’errors a causa del tipus de pell i el sexe.

Ús de la tecnologia

La ciutat de Califòrnia de San Francisco va prohibir recentment l'ús del reconeixement facial per part de les agències de transport i de la llei en reconeixement de les seves imperfeccions i amenaces a les llibertats civils. Però altres ciutats dels Estats Units i d’altres països del món continuen experimentant aquesta tecnologia.

Al Regne Unit, per exemple, les forces policials de Gal·les del Sud, Londres, Manchester i Leicester estan posant a prova aquesta tecnologia, que terroritza organitzacions de llibertats civils com Liberty i Big Brother Watch, que es preocupen pel nombre de falsos partits que es produeixen quan el sistema funciona.

Errors i pors

A la pràctica, això vol dir que les persones innocents són erròniament anomenades potencials delinqüents. Segons el doctor Gebru, aquests problemes haurien de causar preocupació per a tothom, l'ús de mesures preventives i predictives comporta taxes elevades.

Tenint en compte que els nord-americans constitueixen el 37,5% de tots els reclusos dels presos dels Estats Units (segons la Oficina Federal de Presons), malgrat que només representen el 13% de la població nord-americana, els algoritmes mal escrits amb els conjunts de dades disponibles actualment poden predir. que les persones negres tenen més probabilitats de cometre un delicte. No cal que siguis un geni per entendre el que això pot significar per a les polítiques policials i socials.

Més recentment, científics de la Universitat d’Essex han arribat a la conclusió que les coincidències emprades en processos a la policia de Londres eren un 80% equivocades, cosa que podria comportar greus violacions de la justícia i vulneració del dret a la intimitat dels ciutadans.

Un britànic, Ed Bridges, va iniciar una demanda sobre l'ús de la tecnologia de reconeixement facial per la policia del sud de Gal·les es va fer la seva fotografia mentre feia compres i la comissària d'informació britànica Elizabeth Denham va expressar la seva preocupació per la manca d'un marc legal que regulés l'ús de la tecnologia de reconeixement.

Però aquests temors no van impedir que el gegant tecnològic Amazon, vengués la seva eina Rekognition FR a la policia dels Estats Units, malgrat una revolta vacil·lant per part dels accionistes que encara no va provocar res.

Perspectives

Amazon diu que no és responsable de l’ús que els clients utilitzin de la seva tecnologia. Però compareu aquesta relació amb Salesforce, una tecnologia per a la gestió de relacions amb els clients, que ha desenvolupat la seva pròpia eina de reconeixement d’imatges anomenada Einstein Vision.

"La tecnologia de reconeixement facial pot ser adequada en una presó per fer un seguiment dels presos o evitar la violència de bandes", va dir BBC Salesforce, expert en intel·ligència ètica artificial de la BBC. Però quan la policia va voler utilitzar-lo juntament amb les càmeres de fotos per arrestar persones, l'empresa va trobar això inapropiat. En aquest cas, cal preguntar-se si és necessari utilitzar AI en general en determinats escenaris, i un dels exemples és el reconeixement facial.

Actualment, aquesta tecnologia també és utilitzada pels militars, ja que els proveïdors de tecnologia afirmen que el seu programari no només pot identificar enemics potencials, sinó que també reconeixen un comportament sospitós.