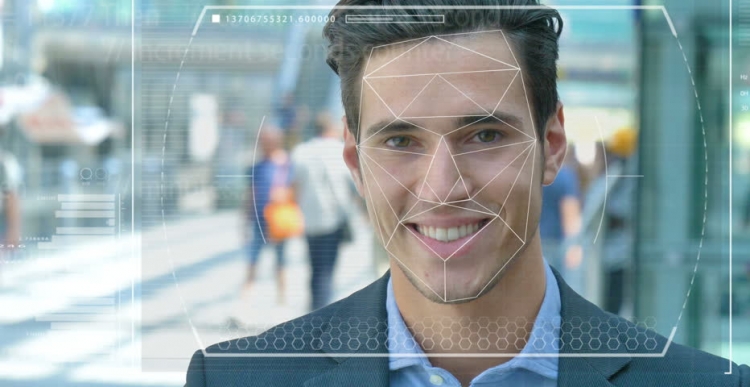

Cảnh sát và lực lượng an ninh trên toàn thế giới đang thử nghiệm các hệ thống nhận dạng khuôn mặt tự động để sử dụng chúng như một công cụ để xác định tội phạm và khủng bố. Nhưng công nghệ này chính xác đến mức nào và nó dễ dàng như thế nào và trí tuệ nhân tạo (AI), trên cơ sở hoạt động của nó, trở thành công cụ đàn áp và áp bức?

Tính năng hệ thống

Hãy tưởng tượng rằng một kẻ khủng bố bị nghi ngờ được gửi đi làm nhiệm vụ tự sát đến một trung tâm thành phố đông dân. Nếu anh ta thả một quả bom, hàng trăm người có thể chết hoặc bị thương nặng. Quy trình quét khuôn mặt trong đám đông bằng cách sử dụng video giám sát cho phép bạn xác định kẻ tấn công và tự động so sánh các đặc điểm của anh ta với các bức ảnh trong cơ sở dữ liệu của những kẻ khủng bố nổi tiếng hoặc những người quan tâm đến vụng trộm.

Trong trường hợp trùng hợp, hệ thống sẽ gióng lên hồi chuông cảnh báo và các lực lượng chống khủng bố phản ứng nhanh được gửi đến nơi họ "vô hiệu hóa" nghi phạm trước khi anh ta có thể kích hoạt chất nổ. Hàng trăm mạng người được cứu nhờ công nghệ hiện đại.

Vấn đề có thể xảy ra trong công việc

Nhưng điều gì sẽ xảy ra nếu công nghệ nhận dạng khuôn mặt (FR) không hoạt động chính xác? Và hóa ra đó không phải là một kẻ khủng bố, mà là một người bình thường không may mắn và anh ta hóa ra giống như một kẻ tấn công. Một cuộc sống vô tội sẽ bị hủy hoại đơn giản vì các chuyên gia quá tin vào một hệ thống sai lầm. Nhưng nếu bạn trở thành một người như vậy thì sao?

Đây chỉ là một trong những tình huống khó xử về đạo đức đối đầu với hệ thống nhận diện khuôn mặt và trí tuệ nhân tạo. Thực sự rất khó để đào tạo các máy móc để có thể nhìn thấy, nhận ra và phân biệt các vật thể và khuôn mặt. Sử dụng thị giác máy tính, đôi khi được gọi là cách đây không lâu, các nhà nghiên cứu đã cố gắng xác định sự khác biệt giữa bánh với nho khô và chihuahua, trở thành một loại thử nghiệm giấy quỳ để xác định tính hiệu quả của công nghệ này.

Khó nhận diện khuôn mặt

Các nhà công nghệ máy tính, Joy Buolamvini, đại diện cho phòng thí nghiệm tại Viện Công nghệ Massachusetts (đồng thời là người sáng lập Liên minh Công lý Thuật toán), và Timnit Gebru, đồng giám đốc kỹ thuật của nhóm Google về các vấn đề đạo đức liên quan đến trí tuệ nhân tạo, cho thấy hệ thống nhận dạng khuôn mặt rất khó khăn. phân biệt nam và nữ nếu da đủ tối. Hệ thống khá thường xuyên nhầm phụ nữ có làn da tối màu cho nam giới.

Khoảng 130 triệu người Mỹ trưởng thành đã có mặt trên cơ sở dữ liệu nhận dạng khuôn mặt, tiến sĩ Gebru cho biết vào tháng 5 tại Hội nghị thượng đỉnh về AI ở Geneva. Tuy nhiên, các bộ dữ liệu ban đầu chứa hầu hết các đại diện của chủng tộc da trắng, trong số đó có nhiều người hơn. Do đó, khi nhận ra những người có loại da sẫm màu hơn, vẫn có một tỷ lệ lỗi rất lớn do loại da và giới tính.

Sử dụng công nghệ

Thành phố San Francisco ở California gần đây đã cấm sử dụng nhận dạng khuôn mặt của các cơ quan vận tải và thực thi pháp luật để công nhận sự không hoàn hảo và các mối đe dọa đối với tự do dân sự. Nhưng các thành phố khác ở Hoa Kỳ và các quốc gia khác trên thế giới vẫn tiếp tục trải nghiệm công nghệ này.

Ví dụ, ở Anh, các lực lượng cảnh sát ở Nam Wales, London, Manchester và Leicester đang thử nghiệm công nghệ này, điều gây kinh hoàng cho các tổ chức tự do dân sự như Liberty và Big Brother Watch, lo ngại về số lượng trận đấu giả xảy ra trong quá trình vận hành hệ thống.

Sai lầm và nỗi sợ hãi

Trong thực tế, điều này có nghĩa là những người vô tội bị gọi nhầm là tội phạm tiềm năng. Theo Tiến sĩ Gebru, những vấn đề như vậy chắc chắn sẽ gây lo ngại cho mọi người, việc sử dụng các biện pháp phòng ngừa và dự đoán như vậy liên quan đến tỷ lệ cao.

Cho rằng người Mỹ da đen chiếm 37,5% tổng số tù nhân tại Hoa Kỳ (theo Cục Nhà tù Liên bang), mặc dù thực tế họ chỉ chiếm 13% dân số Hoa Kỳ, các thuật toán được viết kém bằng cách sử dụng bộ dữ liệu hiện có những người da đen có nhiều khả năng phạm tội. Bạn không cần phải là một thiên tài để hiểu điều này có nghĩa gì đối với các chính sách xã hội và cảnh sát.

Gần đây, các nhà khoa học từ Đại học Essex đã đưa ra kết luận rằng sự trùng hợp được sử dụng trong các thử nghiệm ở cảnh sát London là 80% sai, có khả năng dẫn đến vi phạm nghiêm trọng công lý và xâm phạm quyền riêng tư của công dân.

Một người Anh, Ed Bridges, đã bắt đầu một vụ kiện về việc sử dụng công nghệ nhận dạng khuôn mặt của cảnh sát Nam Wales sau khi bức ảnh của anh được chụp khi anh đang đi mua sắm, và Ủy viên Thông tin Anh Elizabeth Denham bày tỏ lo ngại về việc thiếu khung pháp lý điều chỉnh việc sử dụng công nghệ nhận dạng.

Nhưng những lo ngại như vậy không ngăn được gã khổng lồ công nghệ Amazon bán công cụ Rekognition FR của mình cho lực lượng cảnh sát Hoa Kỳ, mặc dù một cuộc bạo loạn do dự của các cổ đông vẫn không dẫn đến điều gì.

Triển vọng

Amazon cho biết họ không chịu trách nhiệm về cách khách hàng sử dụng công nghệ của mình. Nhưng so sánh mối quan hệ này với Salesforce, một công nghệ quản lý quan hệ khách hàng, đã phát triển công cụ nhận dạng hình ảnh của riêng mình có tên Einstein Vision.

Công nghệ nhận dạng khuôn mặt có thể thích hợp trong một nhà tù để theo dõi các tù nhân hoặc ngăn chặn bạo lực băng đảng, ông nói, BBC Salesforce, một chuyên gia về trí tuệ nhân tạo đạo đức tại BBC. Nhưng khi cảnh sát muốn sử dụng nó cùng với máy ảnh khi bắt người, công ty thấy điều này không phù hợp. Trong trường hợp này, người ta nên hỏi liệu có cần thiết phải sử dụng AI nói chung trong các tình huống nhất định hay không, và một trong những ví dụ là nhận dạng khuôn mặt.

Hiện tại, công nghệ này cũng được quân đội sử dụng, vì các nhà cung cấp công nghệ tuyên bố rằng phần mềm của họ không chỉ có thể xác định kẻ thù tiềm năng mà còn nhận ra hành vi đáng ngờ.