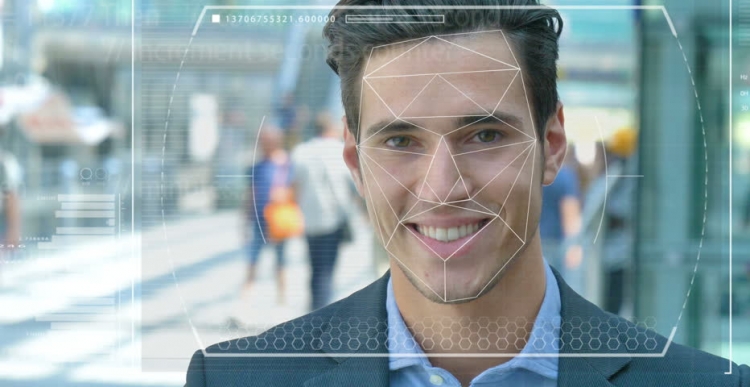

Полиција и снаге безбедности широм света тестирају аутоматизоване системе препознавања лица како би их користили као алат за идентификацију криминалаца и терориста. Али колико је тачна та технологија и колико лако и вештачка интелигенција (АИ), на основу које делује, постају оруђе прогона и угњетавања?

Функције система

Замислите да је осумњичени терориста упућен на самоубилачку мисију у густо насељено градско средиште. Ако баци бомбу, стотине људи могу умрети или бити озбиљно повређене. Процедура скенирања лица у гомили помоћу видео надзора омогућава вам да идентификујете нападача и аутоматски упоређује његове карактеристике са фотографијама у бази познатих терориста или "особа од интереса" безбедносним службама.

У случају случајности, систем подиже аларм, а антитерористичке снаге брзе реакције шаљу се на место где „неутралишу“ осумњиченог пре него што он активира експлозив. Стотине живота спасило се захваљујући савременој технологији.

Могући проблеми на послу

Али шта ако технологија препознавања лица (ФР) не ради исправно? А испоставило се да није терориста, већ обична особа која само није имала среће и појавио се као да је нападач. Невин живот би био једноставно уништен јер су и експерти веровали у погрешан систем. Али шта ако се испостави да сте таква особа?

Ово је само једна од етичких дилема која се суочава са системом препознавања лица и вештачке интелигенције. Стварно је тешко обучити машине да „виде“, препознају и разликују предмете и лица. Користећи рачунарски вид, како се понекад назива, не тако давно, истраживачи су покушали да утврде разлику између лепиња са грожђицама и чиваве, што је постало својеврсни лакмус тест за утврђивање ефикасности ове технологије.

Потешкоће с препознавањем лица

Компјутерски технолози Јои Буоламвини, представник лабораторија Массацхусеттс Институте оф Тецхнологи (а истовремено оснивач Алгоритхмиц Јустице Леагуе) и Тимнит Гебру, технички ко-директор Гооглеовог тима о етичким питањима везаним за вештачку интелигенцију, показали су да је систем препознавања лица тежак разликује мушкарце и жене ако им је кожа довољно тамна. Систем прилично често погрешно узима жене са тамном кожом.

„Око 130 милиона одраслих Американаца већ је на базама података о препознавању лица“, рекао је др Гебру у мају на АИ за добар самит у Женеви. „Али оригинални сетови података садрже углавном представнике беле расе, међу којима има много више мушкараца.“ Стога, приликом препознавања људи тамнијег типа коже, још увек постоји огроман проценат грешака због типа коже и пола.

Употреба технологије

Калифорнијски град Сан Франциско недавно је забранио употребу препознавања лица од стране превоза и агенција за спровођење закона ради препознавања његових несавршености и претњи грађанским слободама. Али други градови у Сједињеним Државама и другим државама света и даље доживљавају ову технологију.

На пример, у Великој Британији, полицијске снаге у Јужном Велсу, Лондону, Манцхестеру и Леицестеру тестирају ову технологију, која ужасне организације за грађанске слободе, попут Либертија и Биг Бротхер Ватцх-а, које су забринуте због броја лажних мечева које се дешавају током рада система.

Грешке и страхови

У пракси то значи да невине људе погрешно називају потенцијалним злочинцима. Према др Гебру, овакви проблеми би свакако требали да изазову забринутост за све, употреба таквих превентивних и предиктивних мера укључује високе стопе.

С обзиром да црни Американци чине 37,5% свих затвореника у Сједињеним Државама (према Федералном заводу за затвор), упркос чињеници да чине само 13% популације у САД-у, лоше написани алгоритми који користе тренутно доступне скупове података могу предвидјети да су вероватније да ће црнци починити злочин. Не морате бити геније да бисте схватили шта то може значити за полицију и социјалну политику.

У новије време, научници са Универзитета у Ессексу дошли су до закључка да су случајности коришћене у суђењима лондонске полиције погрешно 80%, што би потенцијално могло довести до озбиљних кршења правде и кршења права грађана на приватност.

Један Британац, Ед Бридгес, започео је парницу због употребе технологије препознавања лица од стране полиције Јужног Велса његова фотографија је снимљена док је био у куповини, а британска комесарка за информације Елизабетх Денхам изразила је забринутост због недостатка правног оквира који регулише употребу технологије признавања.

Али такви страхови нису спречили технолошког гиганта Амазон-а да прода свој алат Рекогхибитион ФР америчким полицијским снагама, упркос неодлучном нереду акционара који још увек није довео до ничега.

Перспективе

Амазон каже да није одговоран за то како купци користе његову технологију. Али упоредите овај однос са Салесфорце-ом, технологијом за управљање односима са купцима, која је развила сопствено средство за препознавање слике под називом Еинстеин Висион.

„Технологија препознавања лица може бити прикладна у затвору за праћење затвореника или спречавање насиља у банди“, рекао је ББЦ Салесфорце, експерт за етичку вештачку интелигенцију на ББЦ-у. Али када је полиција хтела да је користи заједно са камерама приликом хапшења људи, компанија је сматрала да то није примерено. У овом случају треба се запитати да ли је уопште потребно користити АИ у одређеним сценаријима, а један од примера је препознавање лица.

Тренутно ову технологију користи и војска, јер провајдери технологије тврде да њихов софтвер не може само да идентификује потенцијалне непријатеље, већ и препознаје сумњиво понашање.