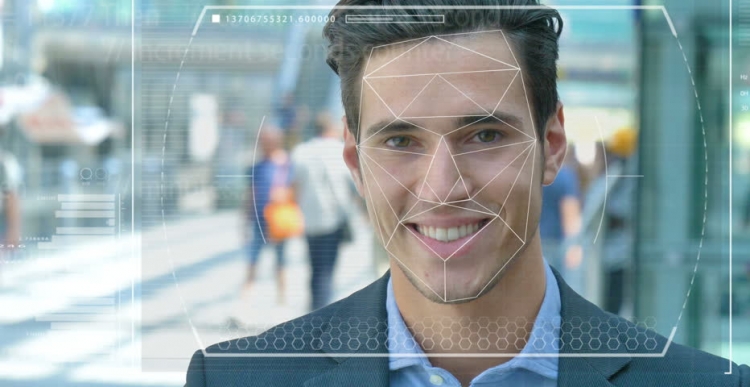

Policajné a bezpečnostné sily na celom svete testujú automatizované systémy rozpoznávania tváre, aby ich mohli použiť ako nástroj na identifikáciu zločincov a teroristov. Aká presná je však táto technológia a ako ľahko sa táto technológia a umelá inteligencia (AI), na základe ktorých fungujú, stali nástrojmi prenasledovania a útlaku?

Funkcie systému

Predstavte si, že podozrivý terorista je vyslaný na samovražednú misiu do husto osídleného centra mesta. Ak hodí bombu, môžu stovky ľudí zomrieť alebo byť vážne zranené. Postup skenovania tváre v dave pomocou video sledovania vám umožňuje identifikovať útočníka a automaticky porovnať jeho vlastnosti s fotografiami v databáze známych teroristov alebo „osôb záujmu“ s bezpečnostnými službami.

V prípade náhody systém vyvolá poplach a protiteroristické sily rýchlej reakcie sú odoslané na miesto, kde podozrivého „neutralizujú“ skôr, ako môže aktivovať výbušniny. Vďaka modernej technológii sa zachránili stovky životov.

Možné problémy v práci

Čo ak však technológia rozpoznávania tváre (FR) nefunguje správne? A ukázalo sa, že nejde o teroristu, ale o obyčajného človeka, ktorý bol len nešťastný a ukázalo sa, že je ako útočník. Nevinný život by bol jednoducho zničený, pretože aj odborníci verili v chybný systém. Ale čo keď sa ukážete, že ste taký človek?

Toto je len jedno z etických dilem, ktoré stoja pred systémom rozpoznávania tváre a umelej inteligencie. Je skutočne ťažké trénovať stroje tak, aby „videli“, rozpoznávali a rozlišovali objekty a tváre. Pomocou počítačového videnia, ako sa to niekedy nazýva, nie je to tak dávno, sa vedci snažili zistiť rozdiel medzi buchtami s hrozienkami a čivavou, ktorá sa stala akýmsi lakmusovým testom na určenie účinnosti tejto technológie.

Problémy s rozpoznaním tváre

Počítačoví technologi, Joy Buolamvini, zastupujúci laboratórium v Massachusettskom technologickom inštitúte (a zároveň zakladateľ Algoritmickej ligy spravodlivosti), a Timnit Gebru, technický pomocný riaditeľ tímu Google pre etické otázky týkajúce sa umelej inteligencie, preukázali, že systém rozpoznávania tváre je zložitý rozlišuje medzi mužmi a ženami, ak je ich pokožka dosť tmavá. Tento systém si často pomýli ženy s tmavou pokožkou pre mužov.

"Asi 130 miliónov dospelých Američanov už je v databázach rozpoznávania tváre," uviedol Dr. Gebru v máji na AI pre dobrý samit v Ženeve. "Pôvodné súbory údajov však väčšinou obsahujú predstaviteľov bielej rasy, medzi ktorými je omnoho viac mužov." Preto pri rozpoznávaní ľudí s tmavším typom pleti stále existuje veľké percento chýb v dôsledku typu pleti a pohlavia.

Využitie technológie

Kalifornské mesto San Francisco nedávno zakázalo používanie rozpoznávania tváre dopravnými a orgánmi činnými v trestnom konaní ako uznanie jeho nedostatkov a hrozieb pre občianske slobody. Ale ďalšie mestá v Spojených štátoch a ďalších krajinách sveta naďalej prežívajú túto technológiu.

Napríklad vo Veľkej Británii policajné sily v Južnom Walese, Londýne, Manchestri a Leicesteri testujú túto technológiu, ktorá vydesí organizácie pre občianske slobody, ako sú Liberty a Big Brother Watch, ktoré sa obávajú počtu nepravdivých zápasov, ku ktorým dochádza počas prevádzky systému.

Chyby a obavy

V praxi to znamená, že nevinní ľudia sa mylne nazývajú potenciálnymi zločincami. Podľa Dr. Gebrua by takéto problémy určite mali vyvolávať obavy u každého, použitie takýchto preventívnych a prediktívnych opatrení vyžaduje vysoké miery.

Vzhľadom na to, že čierni Američania tvoria v Spojených štátoch 37,5% všetkých väzňov (podľa Federálneho úradu pre väzenia), napriek tomu, že tvoria iba 13% americkej populácie, je možné predpovedať zle napísané algoritmy využívajúce v súčasnosti dostupné súbory údajov že čierni ľudia častejšie spáchajú zločin. Nemusíte byť génius, aby ste pochopili, čo to môže znamenať pre policajnú a sociálnu politiku.

Nedávno vedci z univerzity v Essexe dospeli k záveru, že náhody použité pri súdnych konaniach na londýnskej polícii boli nesprávne z 80%, čo by mohlo viesť k vážnemu porušeniu spravodlivosti a porušeniu práva občanov na súkromie.

Jeden Brit, Ed Bridges, začal súdny proces o používaní technológie rozpoznávania tvárí políciou v južnom Walese jeho fotografia bola urobená, keď nakupoval, a britská komisárka pre informácie Elizabeth Denham vyjadrila znepokojenie nad nedostatkom právneho rámca upravujúceho používanie technológie uznávania.

Takéto obavy však nezabránili technickému gigantovi Amazonovi predávať svoj nástroj Rekognition FR americkým policajným zborom, napriek váhavým nepokojom zo strany akcionárov, ktoré stále neviedli k ničomu.

vyhliadky

Amazon tvrdí, že nie je zodpovedný za to, ako zákazníci používajú túto technológiu. Tento vzťah však porovnajte s technológiou Salesforce, technológiou pre riadenie vzťahov so zákazníkmi, ktorá vyvinula svoj vlastný nástroj na rozpoznávanie obrázkov s názvom Einstein Vision.

„Technológia rozpoznávania tváre môže byť vo väznici vhodná na sledovanie väzňov alebo predchádzanie násiliu gangov,“ uviedol BBC Salesforce, odborník na etickú umelú inteligenciu v BBC. Keď však polícia chcela pri zatknutí osôb použiť spolu s kamerami, spoločnosť to považovala za nevhodné. Zároveň by sme sa mali opýtať, či by sa AI v určitých scenároch mala používať vôbec, a jedným z príkladov je rozpoznávanie tváre.

V súčasnosti túto technológiu používa aj armáda, pretože poskytovatelia technológií tvrdia, že ich softvér dokáže nielen identifikovať potenciálnych nepriateľov, ale aj rozpoznať podozrivé správanie.