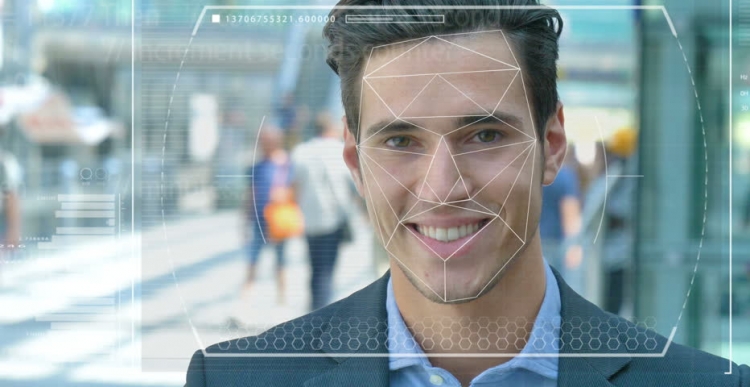

As forças policiais e de segurança em todo o mundo estão testando sistemas automatizados de reconhecimento facial para usá-los como uma ferramenta para identificar criminosos e terroristas. Mas quão exata é essa tecnologia e com que facilidade ela e a inteligência artificial (IA), com base na qual ela funciona, se tornam ferramentas de perseguição e opressão?

Recursos do sistema

Imagine que um terrorista suspeito seja enviado em uma missão suicida para um centro da cidade densamente povoado. Se ele soltar uma bomba, centenas de pessoas podem morrer ou ficar gravemente feridas. O procedimento para escanear rostos em uma multidão usando vigilância por vídeo permite que você identifique um invasor e automaticamente compare suas características com fotografias em um banco de dados de terroristas famosos ou “pessoas de interesse” para serviços de segurança.

Em caso de coincidência, o sistema dispara o alarme e as forças antiterroristas de reação rápida são enviadas para o local onde "neutralizam" o suspeito antes que ele possa ativar os explosivos. Centenas de vidas salvas graças à tecnologia moderna.

Possíveis problemas no trabalho

Mas e se a tecnologia de reconhecimento de rosto (FR) não funcionasse corretamente? E acabou por não ser um terrorista, mas uma pessoa comum que era apenas infeliz e ele acabou por ser como um atacante. Uma vida inocente teria sido simplesmente destruída porque os especialistas também acreditavam em um sistema errôneo. Mas e se você se tornar uma pessoa assim?

Este é apenas um dos dilemas éticos que confronta o sistema de reconhecimento facial e a inteligência artificial. É realmente difícil treinar máquinas para “ver”, reconhecer e distinguir objetos e rostos. Usando a visão computacional, como às vezes é chamado, não muito tempo atrás, os pesquisadores tentaram determinar a diferença entre pãezinhos com passas e um chihuahua, que se tornou uma espécie de teste decisivo para determinar a eficácia dessa tecnologia.

Dificuldades de reconhecimento de rosto

Os tecnólogos de informática, Joy Buolamvini, representando o laboratório do Massachusetts Institute of Technology (e ao mesmo tempo o fundador da Algorithmic Justice League), e Timnit Gebru, co-diretor técnico da equipe do Google sobre questões éticas relacionadas à inteligência artificial, mostraram que o sistema de reconhecimento facial é difícil distingue entre homens e mulheres se a sua pele for suficientemente escura. O sistema muitas vezes confundia as mulheres com a pele escura dos homens.

"Cerca de 130 milhões de americanos adultos já estão em bancos de dados de reconhecimento facial", disse Dr. Gebru em maio na AI for Good Summit, em Genebra. “Mas os conjuntos de dados originais contêm principalmente representantes da raça branca, entre os quais há muito mais homens”. Portanto, ao reconhecer pessoas com um tipo de pele mais escura, ainda há uma porcentagem enorme de erros devido ao tipo de pele e gênero.

Uso de tecnologia

A cidade de São Francisco, na Califórnia, recentemente proibiu o uso de reconhecimento de rosto por agências de transporte e policiais, em reconhecimento a suas imperfeições e ameaças às liberdades civis. Mas outras cidades nos Estados Unidos e em outros países do mundo continuam a experimentar essa tecnologia.

No Reino Unido, por exemplo, as forças policiais de Gales do Sul, Londres, Manchester e Leicester estão testando essa tecnologia, que aterroriza as organizações de liberdades civis, como Liberty e Big Brother Watch, que estão preocupadas com o número de correspondências falsas ocorridas durante a operação do sistema.

Erros e medos

Na prática, isso significa que pessoas inocentes são erroneamente chamadas de criminosos em potencial. Segundo o Dr. Gebru, tais problemas devem certamente causar preocupação para todos, o uso de tais medidas preventivas e preditivas envolve altas taxas.

Dado que os americanos negros representam 37,5% de todos os presos nos Estados Unidos (de acordo com o Federal Bureau of Prisons), apesar de constituírem apenas 13% da população dos EUA, algoritmos mal escritos usando os conjuntos de dados atualmente disponíveis podem prever que os negros são mais propensos a cometer um crime. Você não precisa ser um gênio para entender o que isso pode significar para políticas policiais e sociais.

Mais recentemente, cientistas da Universidade de Essex chegaram à conclusão de que as coincidências usadas nos julgamentos da polícia de Londres estavam 80% erradas, o que poderia potencialmente levar a sérias violações da justiça e à violação do direito dos cidadãos à privacidade.

Um britânico, Ed Bridges, iniciou uma ação judicial contra o uso de tecnologia de reconhecimento facial pela polícia de South Wales sua fotografia foi tirada enquanto ele fazia compras, e a comissária britânica de Informação Elizabeth Denham expressou preocupação com a falta de um arcabouço legal que rege o uso da tecnologia de reconhecimento.

Mas tais temores não impediram a gigante de tecnologia Amazon de vender sua ferramenta Rekognition FR para a força policial dos EUA, apesar de um motim hesitante por parte dos acionistas que ainda não levaram a nada.

Perspectivas

A Amazon diz que não é responsável por como os clientes usam sua tecnologia. Mas compare essa relação com a Salesforce, uma tecnologia para gerenciamento de relacionamento com o cliente, que desenvolveu sua própria ferramenta de reconhecimento de imagem chamada Einstein Vision.

"A tecnologia de reconhecimento facial pode ser apropriada em uma prisão para rastrear prisioneiros ou evitar a violência de gangues", disse a BBC Salesforce, especialista em inteligência artificial ética da BBC. Mas quando a polícia queria usá-lo junto com câmeras ao prender pessoas, a empresa achou isso inadequado. Neste caso, deve-se perguntar se é necessário usar a IA em geral em determinados cenários, e um dos exemplos é o reconhecimento facial.

Atualmente, essa tecnologia também é usada pelas forças armadas, pois os provedores de tecnologia afirmam que seu software pode não apenas identificar possíveis inimigos, mas também reconhecer comportamentos suspeitos.