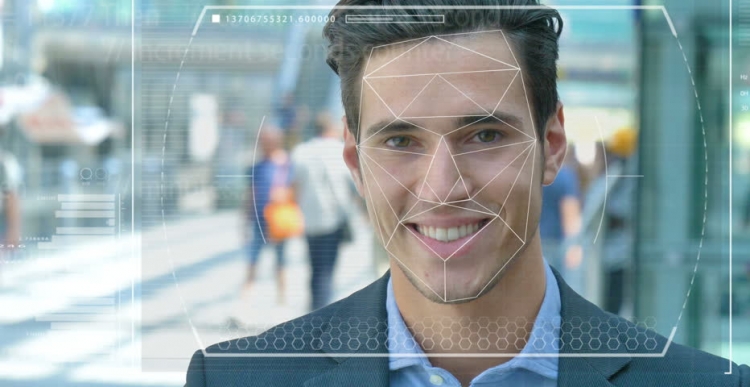

Politi og sikkerhetsstyrker over hele verden tester automatiserte ansiktsgjenkjenningssystemer for å bruke dem som et verktøy for å identifisere kriminelle og terrorister. Men hvor nøyaktig er denne teknologien, og hvor lett er den og kunstig intelligens (AI), på grunnlag av hvilken den fungerer, blitt verktøy for forfølgelse og undertrykkelse?

Systemfunksjoner

Se for deg at en mistenkt terrorist blir sendt på et selvmordsoppdrag til et tett befolket sentrum. Hvis han slipper en bombe, kan hundrevis av mennesker dø eller bli alvorlig skadet. Prosedyren for å skanne ansikter i en mengde ved hjelp av videoovervåking lar deg identifisere en angriper og sammenligner automatisk hans egenskaper med fotografier i en database med kjente terrorister eller "personer av interesse" med sikkerhetstjenester.

Ved tilfeldigheter hever systemet alarmen, og antiterroristkreftene for rask reaksjon blir sendt til stedet der de "nøytraliserer" den mistenkte før han kan aktivere sprengstoffene. Hundrevis av liv reddet takket være moderne teknologi.

Mulige problemer på jobb

Men hva hvis ansiktsgjenkjenning (FR) -teknologi ikke fungerte riktig? Og det viste seg å ikke være en terrorist, men en vanlig person som bare var uheldig og han viste seg å være som en angriper. Et uskyldig liv ville ganske enkelt blitt ødelagt fordi ekspertene også trodde på et feilaktig system. Men hva hvis du viser deg å være en slik person?

Dette er bare et av de etiske dilemmaene som konfronterer ansiktsgjenkjenningssystemet og kunstig intelligens. Det er veldig vanskelig å trene maskiner for å "se", gjenkjenne og skille gjenstander og ansikter. Ved å bruke datasyn, som det noen ganger kalles, for ikke så lenge siden, prøvde forskere å bestemme forskjellen mellom boller med rosiner og en chihuahua, som ble en slags lakmustest for å bestemme effektiviteten til denne teknologien.

Problemer med ansiktsgjenkjenning

Datateknologer, Joy Buolamvini, som representerte laboratoriet ved Massachusetts Institute of Technology (og samtidig grunnleggeren av Algorithmic Justice League), og Timnit Gebru, teknisk meddirektør for Google-teamet om etiske spørsmål relatert til kunstig intelligens, viste at ansiktsgjenkjenningssystemet er vanskelig skiller mellom menn og kvinner hvis huden deres er mørk nok. Systemet tok ofte feil av kvinner med mørk hud for menn.

"Omtrent 130 millioner voksne amerikanere er allerede på databaser for ansiktsgjenkjenning," sa Dr. Gebru i mai på AI for Good Summit i Genève. "Men de originale datasettene inneholder stort sett representanter for den hvite rasen, blant dem er det mye mer menn." Derfor, når du kjenner igjen personer med en mørkere hudtype, er det fortsatt en stor prosentandel av feil på grunn av hudtype og kjønn.

Bruk av teknologi

Byen i San Francisco i California forbød nylig bruk av ansiktsgjenkjenning av transport- og rettshåndhevelsesbyråer i anerkjennelse av dens ufullkommenheter og trusler mot borgerlige friheter. Men andre byer i USA og andre land i verden fortsetter å oppleve denne teknologien.

I Storbritannia tester for eksempel politistyrker i Sør-Wales, London, Manchester og Leicester denne teknologien, som skremmer borgerlige frihetsorganisasjoner som Liberty og Big Brother Watch, som er bekymret for antall falske kamper som oppstår når systemet fungerer.

Feil og frykt

I praksis betyr dette at uskyldige mennesker feilaktig blir kalt potensielle kriminelle. I følge Dr. Gebru, bør slike problemer absolutt føre til bekymring for alle, bruk av slike forebyggende og forutsigbare tiltak innebærer høye priser.

Gitt at svarte amerikanere utgjør 37,5% av alle innsatte i fengsel i USA (ifølge Federal Bureau of Prisons), til tross for at de bare utgjør 13% av den amerikanske befolkningen, kan dårlig skrevet algoritmer ved å bruke de for tiden tilgjengelige datasettene forutsi at det er mer sannsynlig at svarte mennesker begår en forbrytelse. Du trenger ikke å være et geni for å forstå hva dette kan bety for politi og sosialpolitikk.

Nyere har forskere fra University of Essex kommet til den konklusjon at tilfeldighetene som ble brukt i rettssaker i politiet i London var 80% gale, noe som potensielt kan føre til alvorlige krenkelser av rettferdighet og krenkelse av borgernes rett til privatliv.

Den ene briten, Ed Bridges, innledet et søksmål om bruk av ansiktsgjenkjenningsteknologi av South Wales-politiet etter fotografiet hans ble tatt mens han handlet, og den britiske informasjonskommissæren Elizabeth Denham uttrykte bekymring for mangelen på juridiske rammer for bruk av anerkjennelsesteknologi.

Men slik frykt hindret ikke den teknologiske giganten Amazon fra å selge sitt Rekognition FR-verktøy til den amerikanske politistyrken, til tross for et nølende opprør fra aksjonærer som fremdeles ikke førte til noe.

prospekter

Amazon sier at det ikke er ansvarlig for hvordan kunder bruker teknologien. Men sammenlign dette forholdet med Salesforce, en teknologi for styring av kundeforhold, som har utviklet sitt eget bildegjenkjenningsverktøy kalt Einstein Vision.

"Ansiktsgjenkjenningsteknologi kan være passende i et fengsel for å spore fanger eller forhindre gjengvold," sier BBC Salesforce, en etisk ekspert på kunstig intelligens ved BBC. Men da politiet ønsket å bruke det sammen med kameraer når de arresterte mennesker, fant selskapet dette upassende. I dette tilfellet bør man spørre seg om det er nødvendig å bruke AI generelt i visse scenarier, og et av eksemplene er ansiktsgjenkjenning.

For tiden brukes denne teknologien også av militæret, ettersom teknologileverandører hevder at programvaren deres ikke bare kan identifisere potensielle fiender, men også anerkjenne mistenkelig oppførsel.