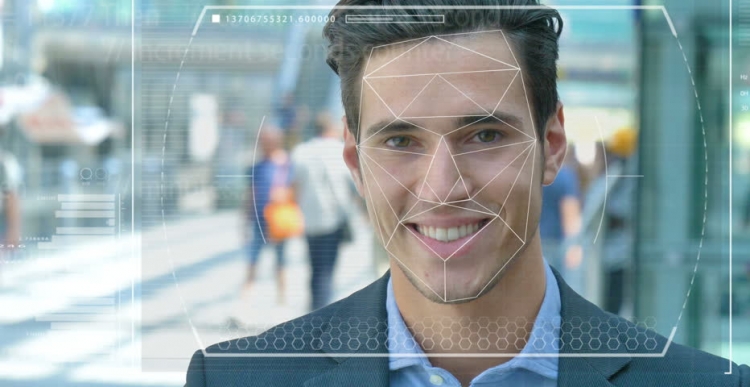

Poliisi ja turvallisuusjoukot ympäri maailmaa testaavat automatisoituja kasvojentunnistusjärjestelmiä käyttääkseen niitä välineenä rikollisten ja terroristien tunnistamiseen. Mutta kuinka tarkka tämä tekniikka on ja kuinka helposti se tapahtuu, ja keinoälystä (AI), jonka perusteella se toimii, tulee vainon ja sorron välineitä?

Järjestelmän ominaisuudet

Kuvittele, että epäilty terroristi lähetetään itsemurhamatkalla tiheään asuttuun keskustaan. Jos hän pudottaa pommin, sadat ihmiset voivat kuolla tai loukkaantua vakavasti. Joukossa olevien kasvojen skannaaminen videovalvonnan avulla antaa sinun tunnistaa hyökkääjä ja vertaa automaattisesti hänen ominaisuuksiaan valokuvien kanssa kuuluisten terroristien tai ”kiinnostuksen kohteena olevien henkilöiden” tietokannassa turvallisuuspalveluihin.

Sattumien sattuessa järjestelmä herättää hälytyksen ja nopean toiminnan terrorisminvastaiset joukot lähetetään paikkaan, jossa ne "neutraloivat" epäillyn ennen kuin hän voi aktivoida räjähteet. Satoja ihmishenkiä pelastettiin nykyaikaisen tekniikan ansiosta.

Mahdolliset ongelmat työssä

Mutta entä jos kasvotunnistustekniikka (FR) ei toiminut oikein? Ja se osoittautui olemaan terroristi, mutta tavallinen ihminen, joka oli vain epäonninen ja hän osoittautui kuin hyökkääjä. Syyttömä elämä olisi yksinkertaisesti tuhottu, koska myös asiantuntijat uskoivat virheelliseen järjestelmään. Mutta entä jos osoittautut sellaiseksi henkilöksi?

Tämä on vain yksi eettisistä ongelmista, jotka kohtaavat kasvojentunnistusjärjestelmän ja tekoälyn. On todella vaikeaa kouluttaa koneita “näkemään”, tunnistamaan ja erottamaan esineet ja kasvot. Tietokonenäköä käyttämällä, kuten sitä toisinaan kutsutaan, ei niin kauan sitten, tutkijat yrittivät selvittää eroa rusinoiden ja chihuahua-pullien välillä, josta tuli eräänlainen lakmustesti tämän tekniikan tehokkuuden määrittämiseksi.

Kasvojen tunnistusvaikeudet

Tietoteknikot, Joy Buolamvini, joka edustaa laboratoriota Massachusetts Institute of Technologyssä (ja samalla Algorithmic Justice League -järjestön perustaja), ja Timnit Gebru, Google-tiimin tekninen apulaisjohtaja tekoälyyn liittyvissä eettisissä kysymyksissä, osoittivat, että kasvojen tunnistusjärjestelmä on vaikea erottaa miesten ja naisten välillä, jos heidän iho on riittävän tumma. Järjestelmä vääristi usein naisia, joilla on tumma iho miehille.

"Noin 130 miljoonaa aikuista amerikkalaista on jo kasvojentunnistustietokannoissa", sanoi tohtori Gebru toukokuussa Genevessä pidetyssä AI for Good -kokouksessa. "Mutta alkuperäiset aineistot sisältävät enimmäkseen valkoisen rodun edustajia, joiden joukossa on paljon enemmän miehiä." Siksi tunnistettaessa tummemman ihotyypin ihmisiä ihon tyypistä ja sukupuolesta johtuvia virheitä on silti valtava määrä.

Teknologian käyttö

Kalifornian kaupunki San Francisco kielsi hiljattain kasvojentunnistuksen käytön kuljetus- ja lainvalvontaviranomaisissa tunnustaakseen sen puutteellisuudet ja uhat kansalaisvapauksille. Mutta muut Yhdysvaltojen ja muiden maailman maiden kaupungit kokevat tätä tekniikkaa edelleen.

Esimerkiksi Isossa-Britanniassa Etelä-Walesin, Lontoon, Manchesterin ja Leicesterin poliisivoimat testaavat tätä tekniikkaa, joka kauhistuttaa kansalaisvapauksien järjestöjä, kuten Liberty ja Big Brother Watch, jotka ovat huolissaan järjestelmän käytön aikana tapahtuvien väärien otteluiden määrästä.

Virheet ja pelot

Käytännössä tämä tarkoittaa, että viattomia ihmisiä kutsutaan virheellisesti potentiaalisiksi rikollisiksi. Dr. Gebruin mukaan tällaisten ongelmien tulisi varmasti aiheuttaa huolta kaikille, tällaisten ennaltaehkäisevien ja ennakoivien toimenpiteiden käyttöön liittyy korkea osuus.

Koska mustat amerikkalaiset muodostavat 37,5% kaikista vankiloista Yhdysvalloissa (liittovaltion vankilaviraston mukaan), vaikka he muodostavat vain 13% Yhdysvaltain väestöstä, huonosti kirjoitetut algoritmit, jotka käyttävät tällä hetkellä saatavilla olevia tietojoukkoja, voivat ennakoida että mustat ihmiset tekevät todennäköisemmin rikoksen. Sinun ei tarvitse olla nero ymmärtääksesi, mitä tämä voi tarkoittaa poliisi- ja sosiaalipolitiikassa.

Äskettäin Essexin yliopiston tutkijat ovat tulleet siihen johtopäätökseen, että Lontoon poliisin oikeudenkäynneissä käytetyt sattumat olivat 80 prosenttia vääriä, mikä saattaa johtaa vakaviin oikeudenloukkauksiin ja kansalaisten yksityisyyden suojaan.

Yksi britti, Ed Bridges, aloitti oikeusjutun kasvotunnistustekniikan käytöstä Etelä-Walesin poliisin jälkeen hänen valokuva on otettu ostoksillaan, ja brittiläinen tiedotusasioista vastaava komission jäsen Elizabeth Denham ilmaisi huolensa tunnustamistekniikan käyttöä sääntelevän oikeudellisen kehyksen puuttumisesta.

Mutta nämä pelot eivät estäneet Amazonin teknillistä jättiläistä myymästä Rekognition FR -työkaluaan Yhdysvaltain poliisivoimille huolimatta osakkeenomistajien epäröivästä mellakasta, joka ei vieläkään johda mihinkään.

tulevaisuudennäkymät

Amazonin mukaan Amazon ei ole vastuussa siitä, kuinka asiakkaat käyttävät sen tekniikkaa. Vertaa tätä suhdetta Salesforcen, asiakassuhdehallinnan tekniikan, joka on kehittänyt oman kuvan tunnistamisen työkalun nimeltään Einstein Vision.

"Kasvontunnistustekniikka voi olla tarkoituksenmukaista vankilassa seurata vankeja tai estää jengi-väkivaltaa", sanoi BBC: n eettisen tekoälyn asiantuntija BBC Salesforce. Mutta kun poliisi halusi käyttää sitä yhdessä kameroiden kanssa pidättäessään ihmisiä, yritys piti tätä sopimattomana. Tässä tapauksessa pitäisi kysyä, onko tarpeen käyttää AI: tä yleensä tietyissä tilanteissa, ja yksi esimerkkeistä on kasvojentunnistus.

Tällä hetkellä tätä tekniikkaa käyttää myös armeija, koska tekniikan toimittajat väittävät, että heidän ohjelmistonsa eivät pysty vain tunnistamaan mahdollisia vihollisia, vaan myös tunnistamaan epäilyttävän käytöksen.