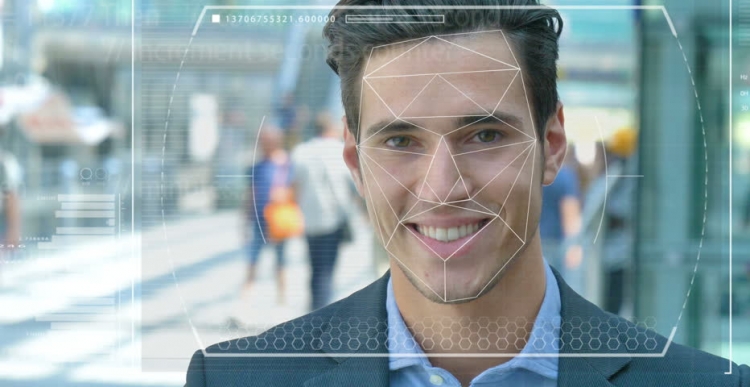

Οι αστυνομικές δυνάμεις και οι δυνάμεις ασφαλείας σε όλο τον κόσμο δοκιμάζουν αυτοματοποιημένα συστήματα αναγνώρισης προσώπων για να τα χρησιμοποιήσουν ως εργαλείο για τον εντοπισμό εγκληματιών και τρομοκρατών. Αλλά πόσο ακριβής είναι αυτή η τεχνολογία και πόσο εύκολα είναι και η τεχνητή νοημοσύνη (AI), βάσει της οποίας λειτουργεί, γίνεται εργαλείο δίωξης και καταπίεσης;

Χαρακτηριστικά συστήματος

Φανταστείτε ότι ένας ύποπτος τρομοκράτης στέλνεται σε μια αποστολή αυτοκτονίας σε ένα πυκνοκατοικημένο κέντρο της πόλης. Αν πέσει μια βόμβα, εκατοντάδες άνθρωποι μπορεί να πεθάνουν ή να τραυματιστούν σοβαρά. Η διαδικασία σάρωσης σε ένα πλήθος χρησιμοποιώντας την επιτήρηση βίντεο σάς επιτρέπει να εντοπίσετε έναν εισβολέα και να συγκρίνετε αυτόματα τα χαρακτηριστικά του με φωτογραφίες σε μια βάση δεδομένων γνωστών τρομοκρατών ή "προσώπων που ενδιαφέρουν" τις υπηρεσίες ασφαλείας.

Σε περίπτωση σύμπτωσης, το σύστημα εγείρει συναγερμό και οι αντιτρομοκρατικές δυνάμεις γρήγορης αντίδρασης αποστέλλονται στον τόπο όπου «εξουδετερώνουν» τον ύποπτο πριν μπορέσει να ενεργοποιήσει τις εκρηκτικές ύλες. Εκατοντάδες ζωές που σώζονται χάρη στη σύγχρονη τεχνολογία.

Πιθανά προβλήματα στην εργασία

Αλλά τι γίνεται αν η τεχνολογία αναγνώρισης προσώπων (FR) δεν λειτουργούσε σωστά; Και αποδείχθηκε ότι δεν ήταν τρομοκράτης, αλλά ένας συνηθισμένος άνθρωπος που ήταν απλώς άτυχος και αποδείχθηκε ότι ήταν σαν εισβολέας. Μια αθώα ζωή θα είχε καταστραφεί απλά επειδή οι ειδικοί πίστευαν επίσης σε ένα λανθασμένο σύστημα. Αλλά τι γίνεται αν αποδειχθεί ότι είναι ένα τέτοιο άτομο;

Αυτό είναι μόνο ένα από τα ηθικά διλήμματα που αντιμετωπίζει το σύστημα αναγνώρισης προσώπου και την τεχνητή νοημοσύνη. Είναι πραγματικά δύσκολο να εκπαιδεύσετε μηχανές για να «βλέπετε», να αναγνωρίζετε και να διακρίνετε αντικείμενα και πρόσωπα. Χρησιμοποιώντας το όραμα των υπολογιστών, όπως αποκαλείται μερικές φορές, όχι πολύ καιρό πριν, οι ερευνητές προσπάθησαν να προσδιορίσουν τη διαφορά ανάμεσα στα κουλούρια με σταφίδες και το τσιουάουα, το οποίο έγινε ένα είδος δοκιμής για τον προσδιορισμό της αποτελεσματικότητας αυτής της τεχνολογίας.

Δυσκολίες αναγνώρισης προσώπου

Οι καθηγητές υπολογιστών, Joy Buolamvini, που εκπροσωπούν το εργαστήριο του Ινστιτούτου Τεχνολογίας της Μασαχουσέτης (και ταυτόχρονα ο ιδρυτής της Αλγοριθμικής Δικαιοσύνης) και ο Timnit Gebru, τεχνικός συν-διευθυντής της ομάδας Google σε ηθικά θέματα που σχετίζονται με την τεχνητή νοημοσύνη, έδειξαν ότι το σύστημα αναγνώρισης προσώπου είναι δύσκολο διακρίνει μεταξύ ανδρών και γυναικών εάν το δέρμα τους είναι αρκετά σκοτεινό. Το σύστημα συνηθίζει συχνά τις γυναίκες με σκούρο δέρμα για τους άνδρες.

"Περίπου 130 εκατομμύρια ενήλικες Αμερικανοί βρίσκονται ήδη σε βάσεις δεδομένων αναγνώρισης προσώπων", δήλωσε ο Δρ Gebru τον Μάιο στο AI για την Καλή Σύνοδο Κορυφής στη Γενεύη. "Αλλά τα αρχικά σύνολα δεδομένων περιέχουν κυρίως εκπροσώπους της λευκής φυλής, μεταξύ των οποίων υπάρχουν πολύ περισσότεροι άνδρες". Επομένως, όταν αναγνωρίζετε άτομα με πιο σκούρο τύπο δέρματος, εξακολουθεί να υπάρχει ένα τεράστιο ποσοστό σφαλμάτων λόγω του τύπου του δέρματος και του φύλου.

Χρήση της τεχνολογίας

Η πόλη Καλιφόρνιας της Καλιφόρνια απαγόρευσε πρόσφατα τη χρήση αναγνώρισης προσώπου από τις υπηρεσίες μεταφορών και επιβολής του νόμου σε αναγνώριση των ατελειών και των απειλών της για τις πολιτικές ελευθερίες. Αλλά άλλες πόλεις στις Ηνωμένες Πολιτείες και σε άλλες χώρες του κόσμου εξακολουθούν να αντιμετωπίζουν αυτή την τεχνολογία.

Στο Ηνωμένο Βασίλειο, για παράδειγμα, οι αστυνομικές δυνάμεις στη Νότια Ουαλία, το Λονδίνο, το Μάντσεστερ και το Leicester δοκιμάζουν αυτή την τεχνολογία, η οποία τρομάζει οργανώσεις πολιτικών ελευθεριών όπως η Liberty και το Big Brother Watch, οι οποίες ανησυχούν για τον αριθμό ψευδών αγώνων που συμβαίνουν όταν λειτουργεί το σύστημα.

Λάθη και Φόβοι

Στην πράξη, αυτό σημαίνει ότι αθώοι άνθρωποι ονομάζονται λάθος δυνητικοί εγκληματίες. Σύμφωνα με τον Δρ Gebru, τέτοια προβλήματα θα πρέπει ασφαλώς να προκαλέσουν ανησυχία για όλους, η χρήση τέτοιων προληπτικών και προληπτικών μέτρων συνεπάγεται υψηλούς ρυθμούς.

Δεδομένου ότι οι μαύροι Αμερικανοί αποτελούν το 37,5% όλων των φυλακισμένων στις Ηνωμένες Πολιτείες (σύμφωνα με το Ομοσπονδιακό Γραφείο Φυλακών), παρά το γεγονός ότι αποτελούν μόνο το 13% του πληθυσμού των ΗΠΑ, οι κακογραφημένοι αλγόριθμοι που χρησιμοποιούν τα υπάρχοντα σύνολα δεδομένων μπορούν να προβλέψουν ότι οι μαύροι άνθρωποι είναι πιο πιθανό να διαπράξουν έγκλημα. Δεν χρειάζεται να είσαι ιδιοφυΐα για να καταλάβεις τι μπορεί να σημαίνει αυτό για την αστυνομία και τις κοινωνικές πολιτικές.

Πιο πρόσφατα, οι επιστήμονες του Πανεπιστημίου του Essex κατέληξαν στο συμπέρασμα ότι οι συγκυρίες που χρησιμοποιήθηκαν σε δίκες στην αστυνομία του Λονδίνου ήταν 80% λανθασμένες, γεγονός που θα μπορούσε ενδεχομένως να οδηγήσει σε σοβαρές παραβιάσεις της δικαιοσύνης και παραβίαση του δικαιώματος της ιδιωτικής ζωής.

Ένας Βρετανός, Ed Bridges, ξεκίνησε μια δίκη για τη χρήση της τεχνολογίας αναγνώρισης προσώπου από την αστυνομία της Νότιας Ουαλίας μετά η φωτογραφία του λήφθηκε ενώ ήταν ψώνια και η Βρετανίδα Επίτροπος Πληροφοριών Elizabeth Denham εξέφρασε ανησυχία για την έλλειψη νομικού πλαισίου που διέπει τη χρήση της τεχνολογίας αναγνώρισης.

Ωστόσο, οι φόβοι αυτοί δεν εμπόδισαν τον τεχνολογικό κολοσσό Amazon να πουλήσει το εργαλείο Rekognition FR στην αμερικανική αστυνομική δύναμη, παρά την διστακτική ταραχή των μετόχων που δεν οδήγησε σε τίποτα.

Προοπτικές

Η Amazon λέει ότι δεν είναι υπεύθυνη για τον τρόπο με τον οποίο οι πελάτες χρησιμοποιούν την τεχνολογία της. Αλλά συγκρίνετε αυτή τη σχέση με την Salesforce, μια τεχνολογία διαχείρισης πελατειακών σχέσεων, η οποία έχει αναπτύξει το δικό της εργαλείο αναγνώρισης εικόνων που ονομάζεται Einstein Vision.

"Η τεχνολογία αναγνώρισης προσώπου μπορεί να είναι κατάλληλη σε μια φυλακή για την παρακολούθηση φυλακισμένων ή για την αποτροπή της βίας από συμμορίες", δήλωσε ο BBC Salesforce, εμπειρογνώμονας δεοντολογικής τεχνητής νοημοσύνης στο BBC. Αλλά όταν η αστυνομία ήθελε να το χρησιμοποιήσει μαζί με τις κάμερες κατά τη σύλληψη ανθρώπων, η εταιρεία το βρήκε ακατάλληλο. Σε αυτή την περίπτωση, πρέπει να ρωτήσετε αν είναι απαραίτητο να χρησιμοποιήσετε γενικά την ΑΠ σε ορισμένα σενάρια και ένα από τα παραδείγματα είναι η αναγνώριση προσώπου.

Επί του παρόντος, αυτή η τεχνολογία χρησιμοποιείται επίσης από τον στρατό, καθώς οι πάροχοι τεχνολογίας υποστηρίζουν ότι το λογισμικό τους δεν μπορεί μόνο να εντοπίσει πιθανούς εχθρούς, αλλά και να αναγνωρίσει ύποπτη συμπεριφορά.