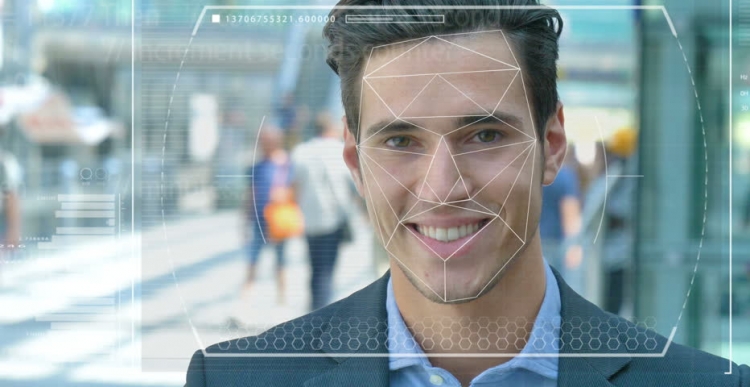

Politi og sikkerhedsstyrker over hele verden tester automatiserede ansigtsgenkendelsessystemer for at bruge dem som et redskab til at identificere kriminelle og terrorister. Men hvor nøjagtig er denne teknologi, og hvor let er den og den kunstige intelligens (AI), på grundlag af hvilken den fungerer, til værktøjer til forfølgelse og undertrykkelse?

Systemfunktioner

Forestil dig, at en mistænkt terrorist sendes til en selvmordsopgave til et tæt befolket centrum. Hvis han lægger en bombe, kan hundreder af mennesker dø eller blive alvorligt såret. Proceduren for scanning af ansigter i en mængde ved hjælp af videoovervågning giver dig mulighed for at identificere en angriber og sammenligner automatisk hans egenskaber med fotografier i en database med berømte terrorister eller "personer af interesse" med sikkerhedstjenester.

I tilfælde af tilfældighed hæver systemet alarmen, og antiterroristernes hurtige reaktion sendes til det sted, hvor de "neutraliserer" den mistænkte, inden han kan aktivere sprængstofferne. Hundredvis af liv reddet takket være moderne teknologi.

Eventuelle problemer på arbejdet

Men hvad nu hvis ansigtsgenkendelsesteknologi (FR) ikke fungerede korrekt? Og det viste sig ikke at være en terrorist, men en almindelig person, der bare var uheldig, og han viste sig at være som en angriber. Et uskyldigt liv ville være blevet ødelagt, fordi eksperterne også troede på et fejlagtigt system. Men hvad hvis du viser sig at være sådan en person?

Dette er blot et af de etiske dilemmaer, der konfronterer ansigtsgenkendelsessystemet og kunstig intelligens. Det er virkelig vanskeligt at træne maskiner til at ”se”, genkende og skelne genstande og ansigter. Ved hjælp af computervision, som det nogle gange kaldes, for ikke så længe siden, forsøgte forskere at bestemme forskellen mellem boller med rosiner og en chihuahua, som blev en slags lakmustest til at bestemme effektiviteten af denne teknologi.

Problemer med ansigtsgenkendelse

Computerteknologer Joy Buolamvini, der repræsenterede laboratoriet ved Massachusetts Institute of Technology (og samtidig grundlæggeren af Algorithmic Justice League), og Timnit Gebru, teknisk meddirektør for Google-teamet om etiske spørgsmål i forbindelse med kunstig intelligens, viste, at ansigtsgenkendelsessystemet er vanskeligt skelner mellem mænd og kvinder, hvis deres hud er mørk nok. Systemet forkerte ofte kvinder med mørk hud til mænd.

”Cirka 130 millioner voksne amerikanere er allerede i databaser med ansigtsgenkendelse,” sagde Dr. Gebru i maj på AI for Good Summit i Genève. ”Men de originale datasæt indeholder for det meste repræsentanter for den hvide race, blandt hvilke der er langt flere mænd.” Derfor, når man genkender mennesker med en mørkere hudtype, er der stadig en enorm procentdel af fejl på grund af hudtype og køn.

Brug af teknologi

Den californiske by San Francisco forbød for nylig brug af ansigtsgenkendelse af transport- og retshåndhævelsesorganer i anerkendelse af dens mangler og trusler mod borgerlige frihedsrettigheder. Men andre byer i USA og andre lande i verden oplever fortsat denne teknologi.

I Storbritannien tester for eksempel politistyrker i Syd Wales, London, Manchester og Leicester denne teknologi, der skræmmer borgerlige frihedsorganisationer som Liberty og Big Brother Watch, der er bekymrede over antallet af falske kampe, der opstår under systemets drift.

Fejl og frygt

I praksis betyder det, at uskyldige mennesker fejlagtigt kaldes potentielle kriminelle. Ifølge Dr. Gebru skulle sådanne problemer bestemt give anledning til bekymring for alle, brugen af sådanne forebyggende og forudsigelige foranstaltninger indebærer høje satser.

I betragtning af at sorte amerikanere udgør 37,5% af alle fanger i USA (ifølge Federal Bureau of Prisons), på trods af at de kun udgør 13% af den amerikanske befolkning, kan dårligt skrevet algoritmer ved hjælp af de aktuelt tilgængelige datasæt forudsige at sorte mennesker er mere tilbøjelige til at begå en forbrydelse. Du behøver ikke være et geni for at forstå, hvad det kan betyde for politi og socialpolitik.

For nylig er forskere fra University of Essex kommet til den konklusion, at de tilfældigheder, der blev anvendt i retssager i London-politiet, var 80% forkerte, hvilket potentielt kan føre til alvorlige krænkelser af retfærdighed og krænkelse af borgernes ret til privatliv.

En briton, Ed Bridges, indledte en retssag om brugen af ansigtsgenkendelsesteknologi fra South Wales politi efter hans fotografi blev taget, mens han shoppede, og den britiske informationskommissær Elizabeth Denham udtrykte bekymring over manglen på juridiske rammer for brugen af anerkendelsesteknologi.

Men sådan frygt forhindrede ikke den tech-gigant Amazon fra at sælge sit Rekognition FR-værktøj til den amerikanske politistyrke, på trods af et tøvende oprør fra aktionærer, der stadig førte til intet.

udsigter

Amazon siger, at det ikke er ansvarligt for, hvordan kunder bruger dens teknologi. Men sammenlign dette forhold med Salesforce, en teknologi til styring af kundeforhold, som har udviklet sit eget billedgenkendelsesværktøj kaldet Einstein Vision.

”Ansigtsgenkendelsesteknologi kan være passende i et fængsel til at spore fanger eller forhindre banden vold,” sagde BBC Salesforce, en etisk kunstig intelligensekspert ved BBC. Men da politiet ønskede at bruge det sammen med kameraer, når de arresterede folk, fandt firmaet dette upassende. I dette tilfælde skal man spørge, om det er nødvendigt at bruge AI generelt i visse scenarier, og et af eksemplerne er ansigtsgenkendelse.

I øjeblikket bruges denne teknologi også af militæret, da teknologiudbydere hævder, at deres software ikke kun kan identificere potentielle fjender, men også genkende mistænkelig opførsel.