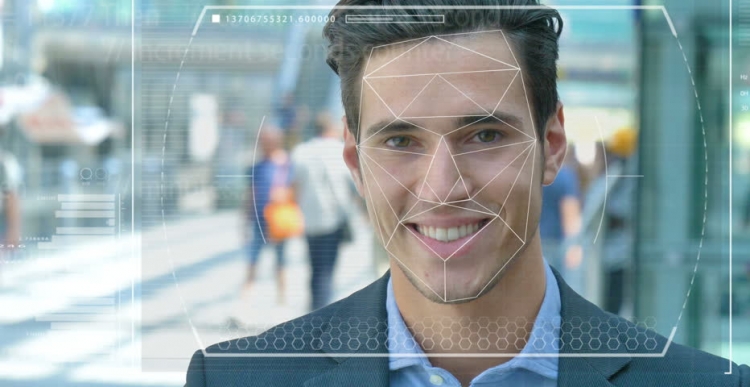

Полицията и силите за сигурност по света тестват автоматизирани системи за разпознаване на лица, за да ги използват като инструмент за идентифициране на престъпници и терористи. Но колко точна е тази технология и колко лесно и изкуственият интелект (AI), въз основа на който функционира, се превръщат в инструменти за преследване и потисничество?

Характеристики на системата

Представете си, че заподозрян терорист е изпратен на самоубийствена мисия в гъсто населен градски център. Ако хвърли бомба, стотици хора могат да загинат или да бъдат сериозно ранени. Процедурата за сканиране на лица в тълпата с помощта на видеонаблюдение ви позволява да идентифицирате нападател и автоматично сравнява неговите характеристики с фотографии в база данни на известни терористи или „лица, представляващи интерес“, към службите за сигурност.

В случай на съвпадение, системата повдига алармата и антитерористичните сили за бърза реакция се изпращат на мястото, където те "неутрализират" заподозрения, преди той да може да активира експлозивите. Стотици животи спасени благодарение на съвременните технологии.

Възможни проблеми в работата

Но какво ще стане, ако технологията за разпознаване на лица (FR) не работи правилно? И се оказа не терорист, а обикновен човек, който просто беше късметлия и той се оказа като нападател. Един невинен живот би бил просто унищожен, защото експертите също вярваха в погрешна система. Но какво ще стане, ако се окажеш такъв човек?

Това е само една от етичните дилеми, която се сблъсква със системата за разпознаване на лица и изкуствения интелект. Наистина е трудно да се обучат машини да „виждат“, разпознават и различават обекти и лица. Използвайки компютърното зрение, както понякога се нарича, не толкова отдавна, изследователите се опитаха да определят разликата между кифлички със стафиди и чихуахуа, което се превърна в един вид лакмусов тест за определяне на ефективността на тази технология.

Трудности при разпознаването на лица

Компютърните учени Джой Буоламинини, представляващи лабораторията в Масачузетския технологичен институт (и в същото време основател на Алгоритмичната лига на справедливостта), и Тимни Гебру, технически директор на екипа на Google по етични въпроси, свързани с изкуствения интелект, показаха, че системата за разпознаване на лица е трудна прави разлика между мъжете и жените, ако кожата им е достатъчно тъмна. Системата доста често заблуждава жени с тъмна кожа за мъже.

„Около 130 милиона пълнолетни американци вече са в бази данни за разпознаване на лица“, каза д-р Гебру през май по време на AI за добра среща на върха в Женева. „Но оригиналните набори от данни съдържат предимно представители на бялата раса, сред които има много повече мъже.“ Следователно, при разпознаване на хора с по-тъмен тип кожа, все още има огромен процент грешки поради тип и пол на кожата.

Използване на технологии

Наскоро калифорнийският град Сан Франциско забрани използването на разпознаване на лица от транспортните и правоприлагащите органи в знак на несъвършенствата и заплахите за гражданските свободи. Но други градове в САЩ и други страни по света продължават да изпитват тази технология.

Във Великобритания например полицейските сили в Южен Уелс, Лондон, Манчестър и Лестър тестват тази технология, което ужасява организации за граждански свободи като Liberty и Big Brother Watch, които са загрижени за броя на фалшивите съвпадения, които се случват, когато системата работи.

Грешки и страхове

На практика това означава, че невинните хора погрешно се наричат потенциални престъпници. Според д-р Гебру подобни проблеми със сигурност трябва да предизвикат безпокойство у всички, използването на такива превантивни и прогнозни мерки включва високи проценти.

Като се има предвид, че чернокожите американци съставляват 37,5% от всички затворници в Съединените щати (според Федералното бюро на затворите), въпреки факта, че те съставляват едва 13% от населението на САЩ, лошо написаните алгоритми, използващи наличните в момента набори от данни, могат да предскажат че по-вероятно е чернокожите да извършат престъпление. Не е нужно да сте гений, за да разберете какво може да означава това за полицията и социалните политики.

Съвсем наскоро учени от университета в Есекс стигнаха до извода, че съвпаденията, използвани при изпитванията в лондонската полиция, са сгрешили 80%, което потенциално може да доведе до сериозни нарушения на правосъдието и нарушаване на правото на гражданите на личния живот.

Един британец, Ед Бриджис, започна съдебно дело за използването на технология за разпознаване на лица от полицията в Южен Уелс след снимката му е направена, докато той пазарува, а британският комисар по информацията Елизабет Денъм изрази притеснение от липсата на правна рамка, регулираща използването на технологията за признаване.

Но такива страхове не попречиха на технологичния гигант Amazon да продаде своя инструмент за възстановяване на FR на американските полицейски сили, въпреки колебливите бунтове на акционерите, които все още не доведоха до нищо.

перспективи

Amazon казва, че не носи отговорност за това как клиентите използват неговата технология. Но сравнете тази връзка с Salesforce, технология за управление на взаимоотношенията с клиенти, която разработи свой собствен инструмент за разпознаване на образи, наречен Ainstein Vision.

„Технологията за разпознаване на лица може да е подходяща в затвора за проследяване на затворници или предотвратяване на насилие с банди“, заяви BBC Salesforce, експерт по етичен изкуствен интелект в BBC. Но когато полицията искаше да го използва заедно с камери при арестуването на хора, компанията намери това за неподходящо. В този случай човек трябва да попита дали е необходимо да се използва AI като цяло в определени сценарии, а един от примерите е разпознаването на лица.

В момента тази технология се използва и от военните, тъй като доставчиците на технологии твърдят, че техният софтуер може не само да идентифицира потенциални врагове, но и да разпознае подозрително поведение.